Der chinesische Entwickler Kuaishou hat die dritte Version des Kling AI-Videogenerierungsmodells vorgestellt.

🚀 Wir präsentieren das Kling 3.0 Modell: Jeder ein Regisseur. Es ist Zeit.

Eine All-in-One-Kreativ-Engine, die wirklich native multimodale Kreation ermöglicht.

— Hervorragende Konsistenz: Ihre Charaktere und Elemente sind immer fest integriert.

— Flexible Videoproduktion: Erstellen Sie präzise 15-Sekunden-Clips… pic.twitter.com/CJBILOdMZs— Kling AI (@Kling_ai) 4. Februar 2026

„Kling 3.0 basiert auf einer umfassend integrierten Lernplattform und ermöglicht so eine wirklich native multimodale Ein- und Ausgabe. Dank nahtloser Audiointegration und fortschrittlicher Kontrolle der Elementkonsistenz verleiht das Modell dem generierten Teil mehr Lebendigkeit und Authentizität“, heißt es in der Ankündigung.

Das Modell vereint mehrere Aufgaben: das Konvertieren von Texten, Bildern und Referenzen in Videos, das Hinzufügen oder Entfernen von Inhalten sowie das Modifizieren und Transformieren von Videos.

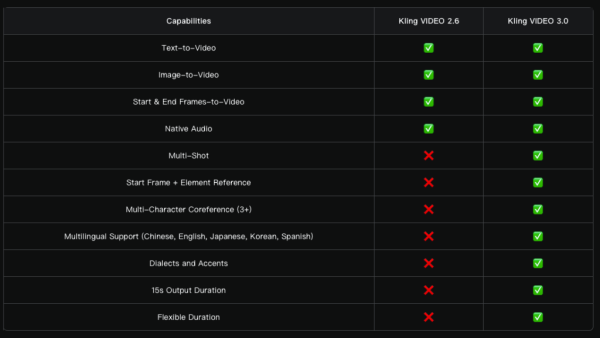

Die Zwischensequenzen wurden auf 15 Sekunden verlängert. Weitere Verbesserungen umfassen ein flexibleres Frame-Management und präzisere Eingabeaufforderungen. Der Realismus wurde insgesamt gesteigert: Die Bewegungen der Charaktere wirken ausdrucksstärker und dynamischer.

Vergleich von Kling VIDEO 3.0 mit Kling VIDEO 2.6. Quelle: Kling AI.

Die neue Multi-Shot-Funktion analysiert die Eingabeaufforderung, um die Szenenstruktur und die Aufnahmetypen zu bestimmen, und passt Kamerawinkel und Bildkomposition automatisch an.

Das Modell unterstützt verschiedene Bearbeitungslösungen: von klassischen Dialogen mit dem Schema „Gegenschuss“ bis hin zu paralleler Erzählweise und Szenen mit Voice-over.

„Das mühsame Schneiden und Bearbeiten von Videos entfällt – eine Generation genügt, um ein filmreifes Video zu erstellen und komplexe audiovisuelle Formen allen Kreativen zugänglich zu machen“, heißt es in der Ankündigung.

Kling 3.0 ist wahrlich ein Riesenschritt für die KI-Videogenerierung! Seht euch diese fantastische Mockumentary von Simon Meyer, Creative Partner bei Kling AI, an! pic.twitter.com/Iyw919s6OJ

— Kling AI (@Kling_ai) 5. Februar 2026

Zusätzlich zur standardmäßigen bildbasierten Videogenerierung unterstützt Kling 3.0 mehrere Bilder als Referenzen sowie Videoquellen als Szenenelemente.

Das Modell erfasst die Merkmale von Figuren, Objekten und der Szene. Unabhängig von Kamerabewegungen und Handlungsverlauf bleiben wichtige Objekte im gesamten Video stabil und gleichbleibend.

Die Entwickler haben die native Audioausgabe verbessert: Das System synchronisiert Sprache genauer mit Gesichtsausdrücken und ermöglicht es, in Szenen mit Dialogen manuell einen bestimmten Sprecher auszuwählen.

Die Liste der unterstützten Sprachen wurde um Chinesisch, Englisch, Japanisch, Koreanisch und Spanisch erweitert. Auch die Dialekt- und Akzenterkennung wurde verbessert.

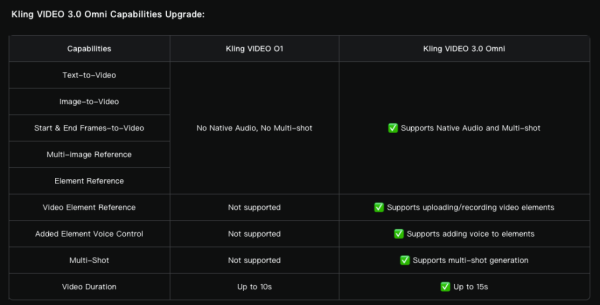

Darüber hinaus hat das Team das multimodale O1-Modell auf Video 3.0 Omni aufgerüstet.

Quelle: Kling AI.

Es ist möglich, eine Audioaufnahme mit einem mindestens drei Sekunden langen Sprachbeitrag hochzuladen und die Stimme hervorzuheben oder ein Video mit einer drei bis acht Sekunden langen Person aufzunehmen, um deren Hauptmerkmale zu erfassen.

Soras Konkurrenten kommen

OpenAI stellte das Sora-Videogenerierungsmodell im Februar 2024 vor. Das Tool sorgte in den sozialen Medien für Aufsehen, die öffentliche Veröffentlichung erfolgte jedoch erst im Dezember.

Knapp ein Jahr später erhielten die Nutzer die Möglichkeit, Videos anhand von Textbeschreibungen zu erstellen, Bilder zu „animieren“ und vorgefertigte Videos zu erweitern.

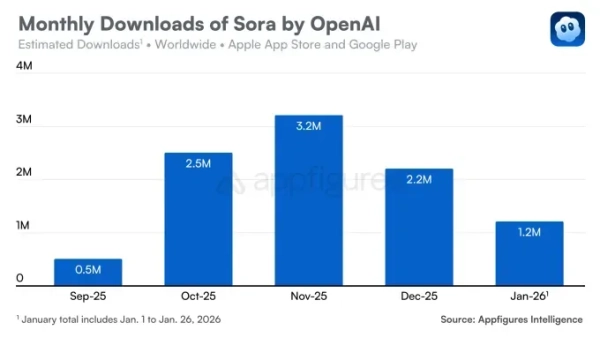

Die iOS-App Sora wurde im September veröffentlicht und erregte sofort großes Aufsehen: Sie wurde am ersten Tag über 100.000 Mal installiert. Der Dienst erreichte die Marke von einer Million Downloads schneller als ChatGPT, obwohl der Zugang nur auf Einladung möglich ist.

Der Trend kehrte sich jedoch bald um. Im Dezember sanken die Downloadzahlen im Vergleich zum Vormonat um 32 %. Im Januar setzte sich der Abwärtstrend fort – die App wurde 1,2 Millionen Mal heruntergeladen.

Quelle: Appfigures.

Der Rückgang ist auf eine Reihe von Faktoren zurückzuführen. Erstens hat sich der Wettbewerb mit Googles Nano Banana-Modell verschärft, was die Position von Gemini gestärkt hat.

Sora konkurriert auch mit Meta AI und dessen Vibes-Funktion. Im Dezember wurde der Marktdruck durch das Startup Runway weiter erhöht, dessen Gen 4.5-Modell in unabhängigen Tests die Konkurrenz übertraf.

Zweitens hatte OpenAI mit Urheberrechtsverletzungen zu kämpfen. Nutzer erstellten Videos mit beliebten Figuren wie SpongeBob Schwammkopf und Pikachu, was das Unternehmen zwang, die Nutzungsbedingungen zu verschärfen.

Die Situation stabilisierte sich im Dezember nach der Unterzeichnung eines Vertrags mit Disney, der es Nutzern ermöglichte, Videos mit den Charakteren des Studios zu erstellen. Dies führte jedoch nicht zu einem Anstieg der Downloads.

Erinnern wir uns daran, dass im Oktober Deepfakes mit Sam Altman auf Sora kursierten.