Nvidias Rubin-Chips machen KI-Infrastruktur zugänglich. Deshalb rücken offene Marktplätze für intelligente Dienste wie Bittensor in den Mittelpunkt.

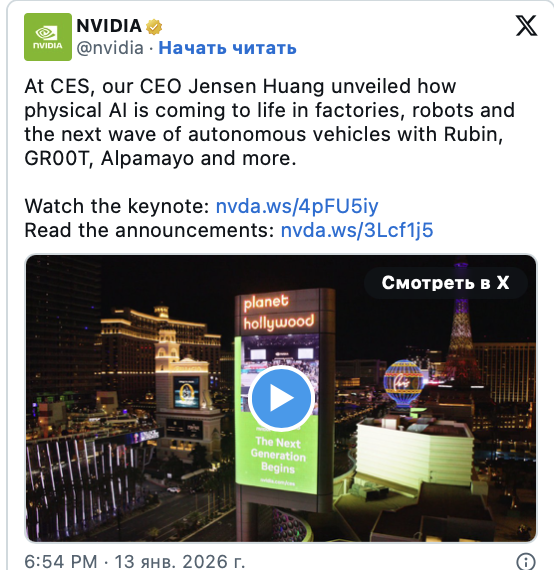

Auf der CES 2026 demonstrierte Nvidia seinen sich wandelnden Ansatz im Bereich der künstlichen Intelligenz. Das Unternehmen konzentriert sich nun nicht mehr auf GPUs für Endverbraucher, sondern auf Rubin, eine Server-Rack-Plattform, die entwickelt wurde, um KI-Inferenz im großen Maßstab zu beschleunigen und kostengünstiger zu gestalten.

Vera Rubin befindet sich in voller Produktion.

Mit der NVIDIA Rubin Plattform haben wir die nächste Generation der KI-Infrastruktur eingeläutet. Sechs neue Chips vereinen sich zu einem KI-Supercomputer, der für KI im großen Maßstab ausgelegt ist.

Hier sind die 5 wichtigsten Dinge, die du wissen solltest 🧵 pic.twitter.com/TiQKUK4eY3

— NVIDIA (@nvidia) 6. Januar 2026

Rubin integriert künstliche Intelligenz in die industrielle Infrastruktur

Auf der CES wurde deutlich, dass Nvidia keine einzelnen Chips mehr verkauft, sondern regelrechte Fabriken für künstliche Intelligenz anbietet.

Rubin ist Nvidias Rechenzentrum der nächsten Generation und Nachfolger von Blackwell. Das Unternehmen vereint die neuesten GPUs, schnellen HBM4-Speicher, proprietäre Prozessoren und Hochgeschwindigkeitsverbindungen in einem einzigen System.

Im Gegensatz zu älteren Plattformen behandelt Rubin ein komplettes Serverrack als eine einzige Recheneinheit. Dies reduziert den Datenaustausch, beschleunigt den Speicherzugriff und senkt die Betriebskosten großer Modelle.

Jetzt können Cloud-Dienste und Unternehmenskunden Systeme mit tiefgreifender Analyse und langem Kontext betreiben – und zahlen deutlich weniger pro Token.

Jensen Huang hat gerade die wichtigste Regel der Branche gebrochen.

Und das erklärt, warum Nvidia 95 % des Marktes für KI-Chips kontrolliert.

Gestern Abend enthüllte er auf der CES Vera Rubin – den neuen KI-Supercomputer, der ab sofort ausgeliefert wird.

Die Serienproduktion hat vor Wochen begonnen.

Aber hier ist das… pic.twitter.com/INWF8ByP88

— Ricardo (@Ric_RTP) 7. Januar 2026

Dies gewinnt zunehmend an Bedeutung, da moderne KI-Systeme längst über einfache Chatbots hinausgewachsen sind. Sie setzen vermehrt mehrere kleinere Modelle und spezialisierte Agenten ein, die in Echtzeit interagieren.

Kostensenkung verändert die Herangehensweise an die Entwicklung künstlicher Intelligenz.

Kostengünstige und flexible Datenanalyse eröffnet neue wirtschaftliche Möglichkeiten für KI. Entwickler können Tausende spezialisierter Modelle anstelle eines einzigen, umständlichen Systems ausführen.

Unternehmen sind heute in der Lage, Dienstleistungen zu entwickeln, bei denen verschiedene Modelle und Agenten für unterschiedliche Aufgaben zuständig sind.

Es entsteht jedoch eine neue Herausforderung: Mit der zunehmenden Modularisierung und Verbreitung von KI wird es notwendig, für jede Anfrage das passende Modell auszuwählen. Entscheidend ist es, die Leistungsfähigkeit der Modelle zu bewerten, Vertrauen zu schaffen und Auszahlungen sicherzustellen.

Cloud-Plattformen können diese Modelle hosten, bieten aber keinen unabhängigen Marktplatz für deren Auswahl.

Diese Nische wird vom Bittensor-Projekt besetzt.

Bittensor verkauft keine Rechenleistung direkt. Das Ökosystem basiert auf einem dezentralen Netzwerk, in dem KI-Modelle um die nützlichsten Antworten konkurrieren. Alle Ranglisten basieren auf On-Chain-Leistungsdaten, und Belohnungen werden in der nativen Token -Währung TAO ausgezahlt.

Es entsteht jedoch ein Governance-Problem. Mit der Modularisierung künstlicher Intelligenz muss entschieden werden, welcher Algorithmus eine bestimmte Anfrage bearbeitet. Leistung muss gemessen, Vertrauen verwaltet und Zahlungen abgewickelt werden. Cloud-Plattformen bieten zwar Hosting, schaffen aber keine neutralen Märkte zur Koordination dieser Prozesse.

Die Rolle des Beißers im Ökosystem

Hier setzt das Bittensor-Projekt an. Das Netzwerk verkauft keine Rechenleistung direkt. Es setzt auf eine dezentrale Struktur, in der KI-Modelle um die besten Ergebnisse konkurrieren. Das System bewertet die Teilnehmer anhand von Leistungsdaten, die in der Blockchain gespeichert werden. Belohnungen werden in Form des nativen TAO- Tokens ausgezahlt.

Jedes Teilnetzwerk fungiert als Marktplatz für eine bestimmte Art von Intelligenz, sei es Textgenerierung, Bildverarbeitung oder Datenanalyse. Erfolgreiche Modelle steigern ihren Einfluss und ihren Umsatz, während schwächere Anbieter an Boden verlieren. Diese Struktur gewinnt mit dem Markteintritt weiterer Algorithmen zunehmend an Wert.

Wechselwirkung zwischen physischen und ökonomischen Ebenen

Die Rubin-Architektur steht nicht im Wettbewerb mit dem Bittensor-Protokoll. Im Gegenteil, sie ermöglicht es dem Wirtschaftsmodell des Projekts, im industriellen Maßstab zu funktionieren. Nvidia senkt die Kosten für den Betrieb von KI und erlaubt so mehr Unternehmen den Einsatz spezialisierter Lösungen. Folglich wächst der Bedarf an einem neutralen System zur Auswahl und Bezahlung dieser Lösungen.

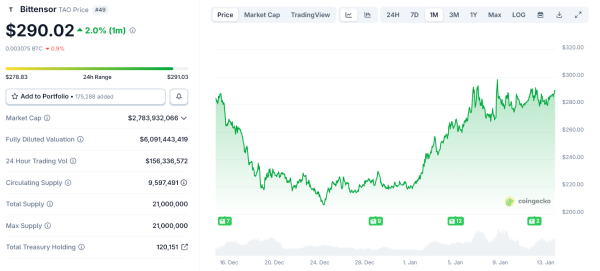

Kursentwicklung von Bittensor ( TAO ) im letzten Monat. Quelle: CoinGecko

Kursentwicklung von Bittensor ( TAO ) im letzten Monat. Quelle: CoinGecko

Nvidia kontrolliert die physikalische Schicht: Chips, Speicher und Netzwerke. Rubin verstärkt diese Kontrolle und beschleunigt so die Berechnungen. Bittensor arbeitet auf der darüberliegenden Schicht. Das Protokoll steuert die Intelligenzökonomie und legt fest, welche Ressourcen genutzt und belohnt werden. Mit dem Übergang der Branche zu agentenbasierten Systemen wird die Zentralisierung dieser ökonomischen Ebene zunehmend schwieriger.

Die Einführung von Rubin in der zweiten Jahreshälfte 2026 wird die Kapazitäten von Rechenzentren erweitern. Dies führt unweigerlich zu einer Zunahme digitaler Agenten, die um Aufgaben in der realen Welt konkurrieren. Offene Netzwerke werden von diesem grundlegenden Wandel profitieren. Sie ersetzen nicht die Nvidia-Infrastruktur, sondern bieten einen organisierten Markt dafür.

Der Beitrag „Wie Nvidias Rubin-Chips die Einführung von Bittensor im Jahr 2026 beschleunigen könnten“ erschien zuerst auf BeInCrypto.